Man wird immer wieder überrascht, auch wenn man sich seit über 20 Jahren intensiv mit dem Klimawandel beschäftigt hat.

Bisher waren Kipp-Punkte im Klimageschehen als unwahrscheinlich oder zumindest nicht in nächster Zukunft von einigen Klimaforschern angekündigt worden.

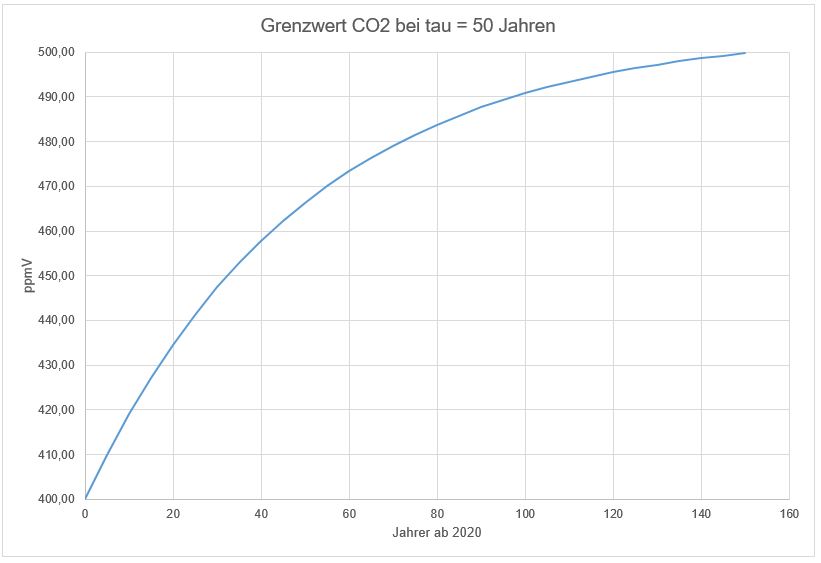

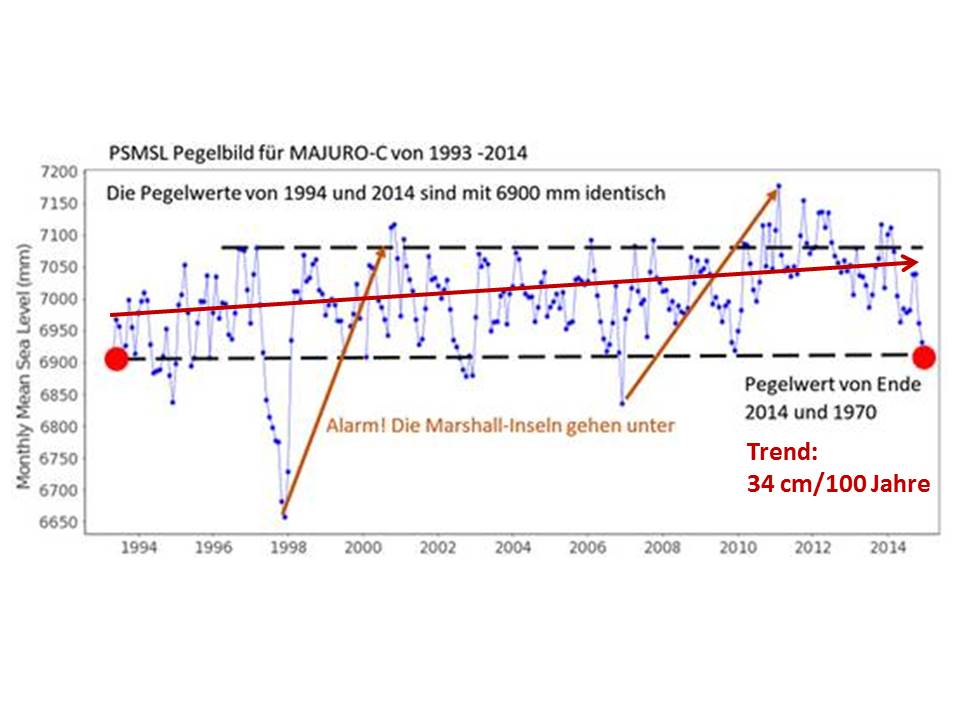

Dazu gehörte auch der Kipp-Punkt der Atlantischen Oszillation (AMOC Atlantic Meridional Overturning Circuit, siehe Abbildung 1). Ein Teil dieser Meeresströmung bei uns im Norden ist auch als Golfstrom bekannt und beschert uns das relativ milde Klima. Ein Abebben desselben würde unser Klima extrem beeinflussen und zu erheblichen niedrigeren mittleren Temperaturen bei uns in der Größenordnung um -10° führen.

Abbildung 1 AMOC (rote Linie nach Norden, Europa)

https://science.nasa.gov/earth/earth-atmosphere/slowdown-of-the-motion-of-the-ocean

Der „Golfstrom“ wird erhalten durch das sehr salzhaltige Wasser an der Oberfläche, das beim Abkühlen im Norden noch einen höheren Salzgehalt erhält und dann auf Grund des höheren Gewichts als das darunter liegende Tiefenwasser absinkt. Dieses kalte Wasser fließt dann zurück nach Süden und erhält den Kreislauf.

Durch Süßwasser Einträge durch im wesentlichen Abschmelzen des Eisschildes Grönlands, so ist die Meinung, wird der Salzgehalt verdünnt bis im Extremfall der AMOC unterbrochen wird!

Im Spiegel Online vom 10.02.2024 (ähnliches auch im Guardian und einer Vielzahl anderer Medien) steht:

„Mithilfe komplexer und teurer Computersysteme hätten die Wissenschaftler erstmals ein Frühwarnsignal entwickelt, heißt es in den Berichten, um einen möglichen Zusammenbruch dieses Systems zu erkennen. Und: Es gebe bereits Anzeichen dafür, dass es genau dazu in kürzerer Zeit kommen werde.

Unklar ist noch der genaue Zeitpunkt. Aber wir können zumindest sagen, dass wir uns auf den Kipppunkt des Klimawandels zubewegen, wird Hauptautor René van Westen, Meeresforscher an der Universität Utrecht, zitiert. Was uns überrascht hat, war die Geschwindigkeit, mit der der Umschwung eintritt, sagt er. Es wird verheerend sein.“

Im Fokus online vom 14.02.2024 steht: „Ein neues Klimamodell sagt voraus, dass der Klimawandel schon bald zum Zusammenbruch bestimmter Meeresströmungen im Atlantik führen könnte. Niederländische Forscher haben in diesem Zusammenhang die Auswirkungen der globalen Erwärmung auf die Atlantische Meridionale Umwälzströmung (AMOC) untersucht.“

Diese Aussage hat mich nun wirklich sehr überrascht! Aber was soll man hier zunächst entgegenhalten? Es waren schließlich Berechnungen durch Modelle mit „komplexen und teuren Computersystemen“.

Wenn dann noch ein bekannter Klimaforscher vom Potsdamer Institut für Klimafolgenforschung dazu sagt, diese Veröffentlichung ist ein großer Fortschritt (gleicher Artikel im Spiegel), dann wird es schwierig, dem Ergebnis etwas entgegenzuhalten:

„Stefan Rahmstorf, physikalischer Ozeanograf an der Universität Potsdam in Deutschland, der nicht an der Studie beteiligt war, bezeichnete die Forschungsergebnisse als großen Fortschritt. » Sie bestätigt, dass die AMOC einen Kipppunkt hat, über den hinaus sie zusammenbricht, wenn der Nordatlantik mit Süßwasser verdünnt wird «, bei CNN zitiert. “

Frühere Studien, in denen der Kipppunkt der AMOC gefunden wurde, hätten viel einfachere Modelle verwendet, sagte Rahmstorf. Dies habe einige Wissenschaftler zu der Hoffnung veranlasst, dass dieser Kipppunkt in komplexeren Modellen nicht gefunden werden könnte. Die neue Studie aus den Niederlanden mache diese Hoffnungen zunichte.“

Dieser Artikel sollte uns alle wieder einmal gewaltig ängstigen, damit wir ja nicht am Alarmistische Klimawandel zweifeln.

Nun wollte ich es doch nicht so einfach akzeptieren, und das machen, was ich immer bei dieser Art Alarmistischen Artikeln mache, ich frage mich, gibt es hierzu Messungen, die diese Modelle bestätigen und vor Allem unter welchen Voraussetzungen wurden die Modelle berechnet, welche Parameter wurden eingesetzt.

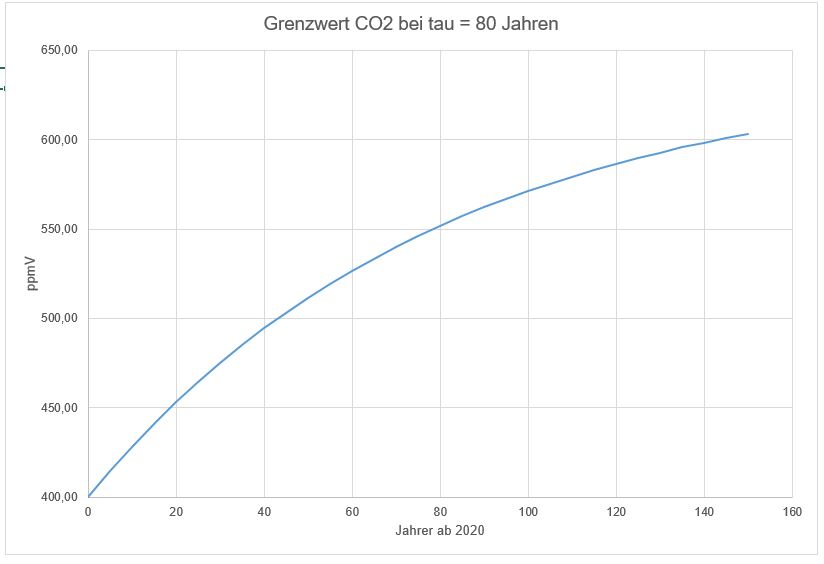

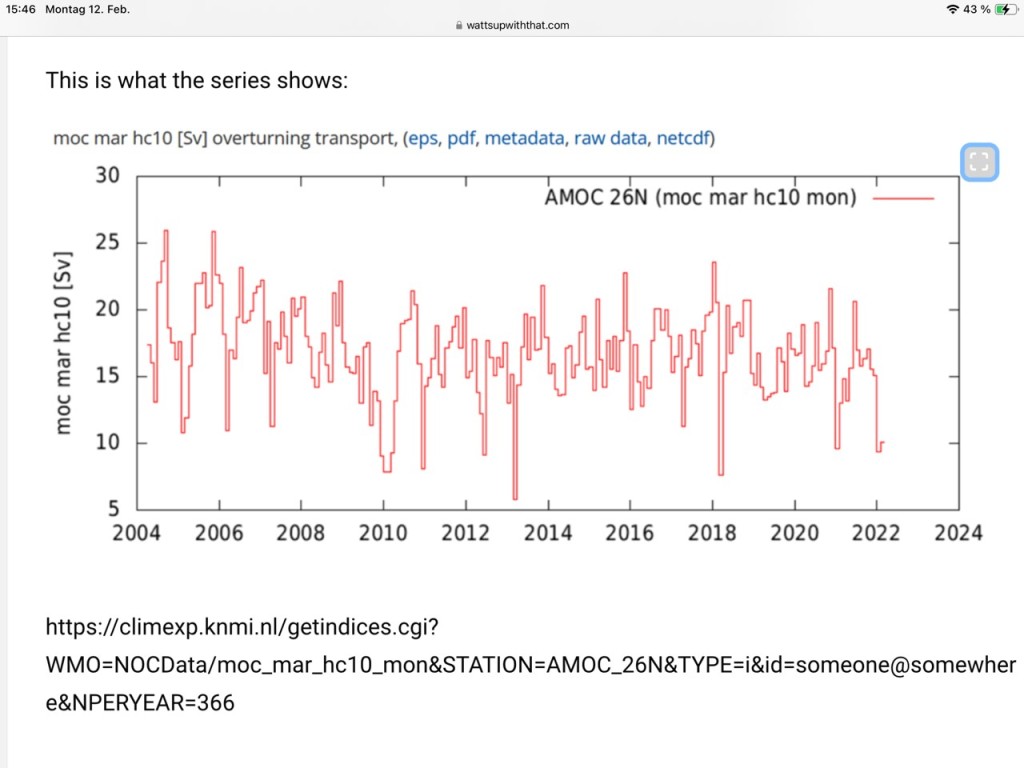

Abbildung 2: Messung der AMOC bei 26 Grad Nord in Sv=10^6 m^3 / sec als Funktion der Zeit von 2004 bis 2022

Zunächst einmal: Aussagekräftige Messungen zur Unterstützung der Ergebnisse dieser neuen Veröffentlichung gibt es nicht!! Abbildung 2! Offensichtlich gab es seit 2010 keine Abnahme dieser Meeresströmung.

Der Parameter im Modell für die Bestimmung des Kipping Punktes war die Eintragung der Menge an Süßwasser in den Atlantik in der nördlichen Hemisphäre, im Wesentlichen durch hypothetisch angenommenes Schmelzwasser pro Jahr des Grönländischen Eisschildes, ohne weitere Klimabetrachtungen.

Bei diesen Überlegungen bin ich im Internet auf den Artikel von Willis Eschenbach gestoßen, der eine überzeugende, leicht satirische Abhandlung geschrieben hat, die ich gerne aufgenommen habe.

(https://wattsupwiththat.com/2024/02/11/tipping-is-optional/)

Im Folgenden gebe ich seine Überlegungen, denen ich mich anschließe, hier wieder.

Beginnen wir mit der Definition der Einheit Sverdrup für Volumenströme bei Ozeanströmungen

1 Sverdrup = 1 Sv = 10^6 m^3 / sec = 1 Million Kubikmeter pro Sekunde.

Sie ist die im Folgenden gebrauchte Einheit!

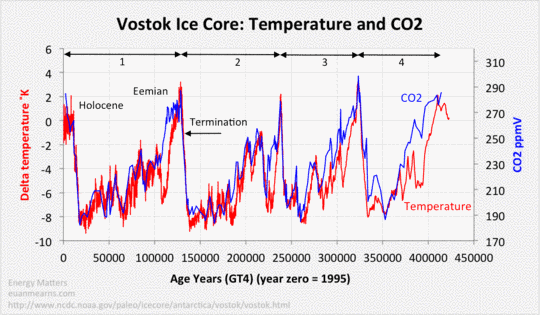

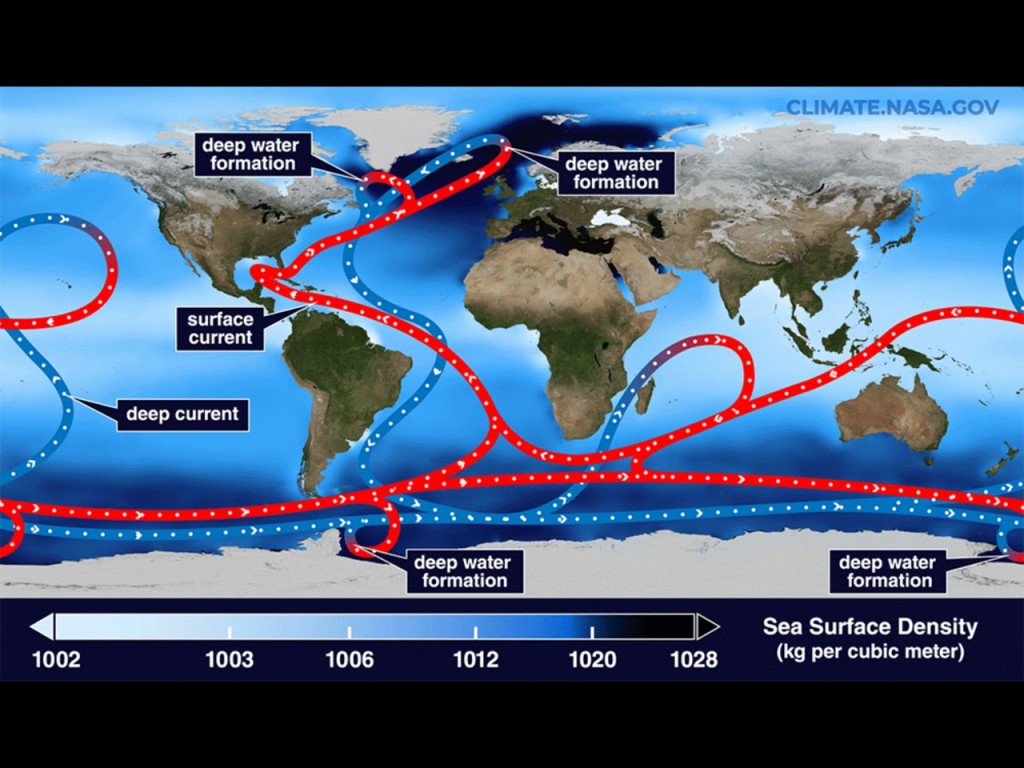

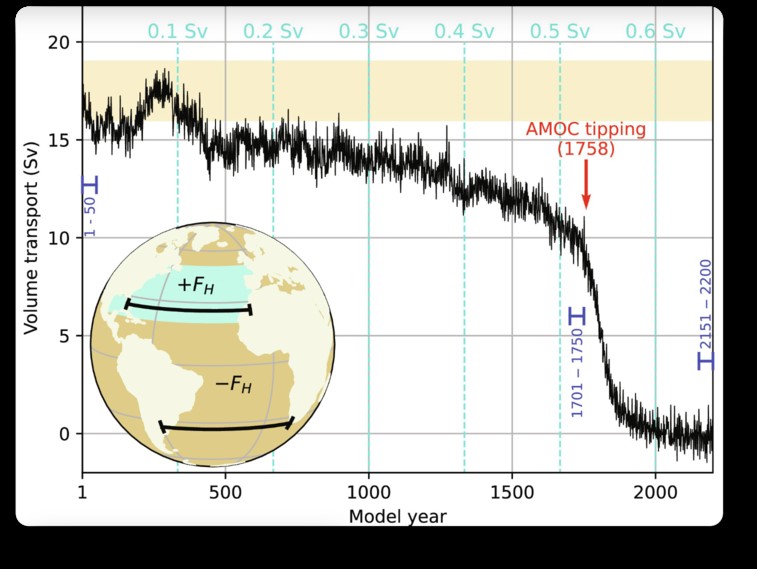

Als nächstes analysieren wir in der nächsten Abbildung 3 aus der Veröffentlichung von Van Westen et al deren Ergebnis.

Abbildung 3: Volumentransport der AMOC als Funktion der Modelljahre (Abszisse unten) und Eintrag an Süßwasser (Abszisse oben) in Sverdrup Sv

Man sieht, dass im Modelljahr 1758, entspricht gemäß unserer Zeitrechnung

AD 1758 + 2024 = AD 3782,

ein Kipppunkt erreicht wird, ab dem dann innerhalb kurzer Zeit von ca. 50 Jahren der AMOC zusammenbricht und versiegt.

Soweit so richtig und keine guten Zukunftsperspektiven. Immerhin, ein Zusammenbruch nicht in den nächsten Jahrzehnten wie Spiegel und die anderen Zeitschriften behaupten, sondern in 17 Jahrhunderten!

Hat denn keiner der Redakteure den Artikel in ScienceAdvances überhaupt gelesen oder verstanden!?

Aber wir sind mit der Berichterstattung noch nicht fertig!

Wie realistisch ist denn der Parameter des Süßwasser Eintrags in den Modellrechnungen!?

Nun eine einfache Überlegung und Rechnung zeigt:

In den 1758 Modelljahren bis zum Kipppunkt wurden von 0,1 Sv zu Beginn gesteigert auf

ca. 0,56 Sv, also im Mittel die Hälfte 0,28 Sv Süßwasser im AMOC eingetragen, also

0,28*10^6 m^3/sec über alle 1758 Modelljahre.

Das ergibt also, da 1 Jahr 31,536 Millionen Sekunden hat, die gewaltige Summe von

0,28*10^6/sec*31,536*10^6 sec*1758m^3*10^ (-9) km^3/m^3

Das sind 15,523 Millionen km^3 an Süßwasser Eintrag!!

Womit könnte man das vergleichen?

Das Süßwasser muss im Wesentlichen durch das Schmelzwasser des grönländischen Eisschildes kommen. Dieses beträgt 2,8 Millionen km^3!!

Die Autoren haben also das 5 1/2 – fache an Süßwasser Eintrag in ihren Modellen angenommen, um zu ihrem Ergebnis zu kommen! Mehr als überhaupt vorhanden ist!!!

Das nordpolare Meereis beträgt übrigens nur 23.000 km^3, kann also auch nicht merklich zum Süßwasser Eintrag beitragen.

Und das alles sollen die Autoren oder die Wissenschaftler – auch die vom PIK – oder die Wissenschaftsredakteure nicht bemerkt oder schlimmer nicht verstanden haben!

Aber Hauptsache man hat wieder eine Alarmistische Klimameldung!

Artikel als PDF:

Filed under: Klima, Meeresspiegel, Wissenschaft, AMOC, Klima, Klimapolitik, Klimawandel, Treibhauseffekt